Wat zijn fotonische chips?

“Er bestaat geen reden waarom iedereen thuis een computer zou willen hebben.” Ken Olsen, medeoprichter van het computerbedrijf Digital Equipment Corporation, sprak deze woorden in 1977. En hij had gelijk, want destijds hadden de meeste mensen niets aan zo’n ding. Pas na zo’n vijftien jaar werden pc’s gemeengoed in huishoudens en wat later kwamen de mobiele telefoon en zijn opvolger de smartphone op. Op een enkele hoogbejaarde na heeft iedereen inmiddels altijd zo’n zakcomputer bij de hand. Vergeleken met de computers uit de jaren 70 zijn dat formidabele apparaten. Wanneer je toen voorspeld zou hebben dat iedereen met een snoerloos plankje zou kunnen filmen, navigeren, beeldbellen en betalen en dat we er in permanent contact met bekenden mee zouden staan, dan zou dat louter meewarige blikken hebben uitgelokt.

Kwantummechanische wetten

Een minicomputer die alles kan en waar je zelfs mondelinge vragen aan kunt stellen, moet wel een enorm geoptimaliseerd apparaat zijn. Dat is inderdaad het geval. Smartphones zouden niet mogelijk zijn zonder uiterst compacte componenten, waaronder vooral de microprocessor. De allereerste processor, de Intel 4004 uit 1971, telde 2300 transistors. Tegenwoordig is 15 miljard geen uitzondering. De kloksnelheid bedroeg 740 kilohertz, oftewel zo’n 4000 keer trager dan wat tegenwoordig de norm is. En met 10 micrometer waren de transistors op deze oerchip ook nog eens zo’n 1000 tot 2000 keer groter dan de 10- of 5-nanometer-componenten op de huidige chips.

Hoe fantastisch ook, dit feest kan volgens veel deskundigen niet eeuwig doorgaan. Chips zijn gemaakt van silicium. Een siliciumatoom heeft een doorsnee van ruwweg 0,2 nanometer. De grenzen van de miniaturisering zijn dus in zicht. Daar komt bij dat elektronen, die de dragers van informatie zijn in deze transistors, op deze schaal grillig gedrag vertonen. De kwantummechanische wetten die het gedrag van elementaire deeltjes beschrijven, staan toe dat elektronen zich plotseling op een andere plek bevinden of zelfs op twee plekken tegelijk. Uiteraard is dit niet best voor de stabiliteit van een chip.

System on a chip

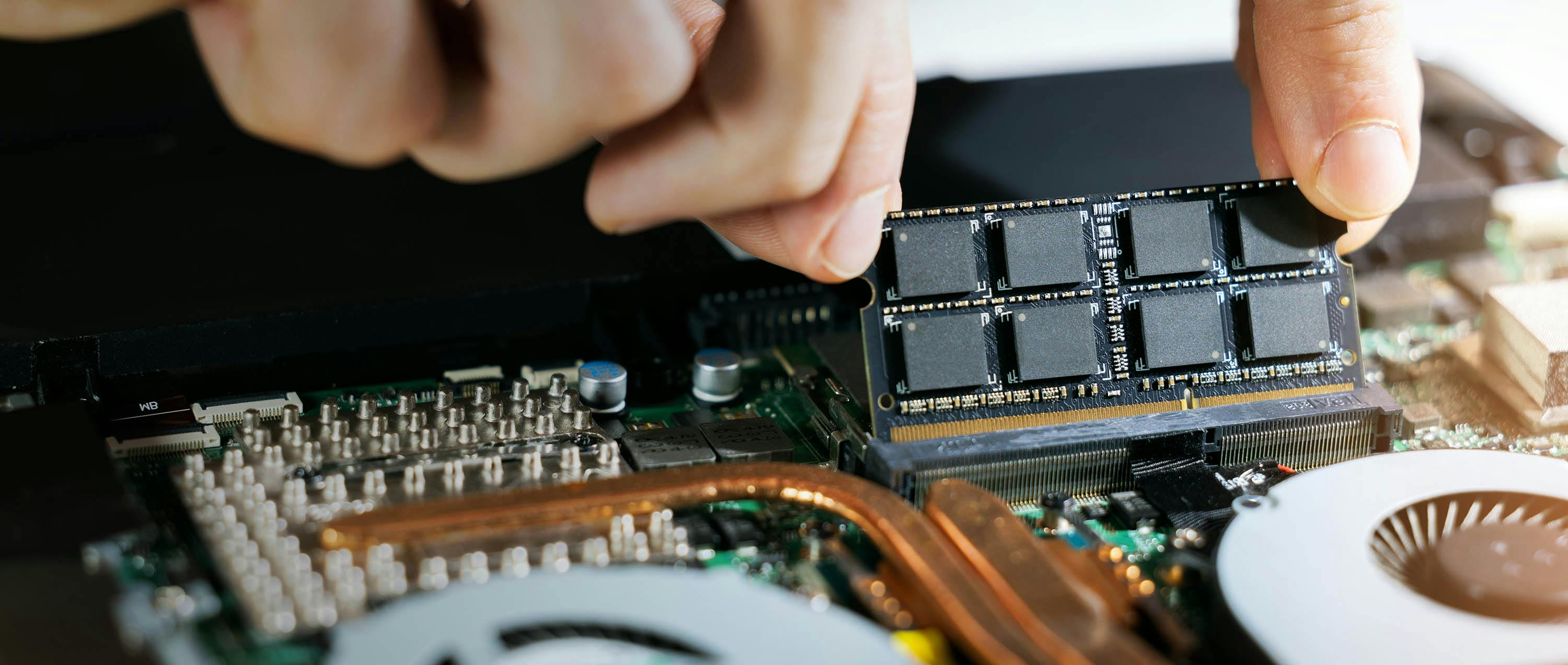

Volgens pessimisten komt hiermee een einde aan de Wet van Moore, de vuistregel dat het aantal transistors op een chip pakweg elke twee jaar verdubbelt. Nieuwe processors, zo vrezen ze, zullen niet meer de spectaculaire prestatiesprongen laten zien waaraan we gewend en verslaafd zijn geraakt. Nu zijn ontwerpers van chips gelukkig niet voor één gat te vangen. Het succes van de smartphone is gebaseerd op de uitvinding van de ‘system on a chip’, oftewel SoC. Door de processor, de grafische processor, het werkgeheugen en andere vitale onderdelen op één chip samen te brengen, kan flink wat ruimte en energie worden bespaard. Een laag energieverbruik is essentieel in mobiele apparaten: de accu raakt minder snel leeg en er hoeft minder warmte te worden afgevoerd. Traditionele laptopprocessors, zoals die van Intel, worden bij intensieve taken zo heet dat de chip zelfs bij een loeiende ventilator zijn kloksnelheid moet terugschakelen. SoC’s, zoals de M1-chip in de nieuwste laptops van Apple, blijven dermate koel dat een ventilator meer luxe dan noodzaak is. De nieuwste MacBook Air bevat er dan ook geen.

De regel dat het aantal transistors elke twee jaar verdubbelt, gaat niet zo lang meer mee

Geen vreemde eend

Maar hoe slim ook ontworpen, ook SoC’s lopen tegen de grenzen van de miniaturisering aan. Daarom beginnen chipontwerpers aan het fundamentele karakter van de traditionele siliciumchip te morrelen. Zoals we al zagen, is een chip een apparaat waarin groepjes elektronen heen en weer geschoven worden. Dat zijn elementaire deeltjes met een massa en een elektrische lading. Ze zijn daardoor gemakkelijk te manipuleren. Maar wanneer ze bewegen, warmen ze hun omgeving op. Er bestaat ook een deeltje dat dit nadeel niet heeft: het foton. Dit deeltje, feitelijk het kwantum van het elektromagnetische veld, is bepaald geen vreemde bijt in de ICT-industrie. Het wordt al jaren gebruikt om data te verzenden door glasvezelkabels en ook LiDAR berust op het uitzenden en opvangen van fotonen. Maar zodra deze deeltjes in een computer aankomen, geven ze het estafettestokje door aan elektronen, zodat er bewerkingen op kunnen worden uitgevoerd. Het onderzoeksveld dat zich met deze wisselwerking tussen fotonen en elektronen bezig houdt, wordt fotonica genoemd.

Grofstoffelijk

Fotonen kunnen dus worden gebruikt om data te verzenden en de omgeving te scannen, maar vooralsnog niet om te rekenen. Dat is teleurstellend, want fotonische schakelingen zijn in theorie ontzettend snel en erg energiezuinig.

Martijn Heck is sinds 2020 hoogleraar fotonica aan de Technische Universiteit Eindhoven, na eerder werkzaam te zijn geweest aan de Universiteit van Aarhus in Denemarken, waar hij in 2013 de Photonic Integrated Circuits-groep oprichtte. Het probleem met fotonica, zo zegt hij, is dat het niet schaalt. Het is vooralsnog dus onmogelijk fotonische schakelingen te maken die even klein zijn als elektronische transistors. Alleen al om die reden zal fotonica niet de transistor vervangen, aldus Heck tijdens een videogesprek. “Fotonica is te grofstoffelijk.” De voordelen van fotonica blijken subtieler. Fotonica, zo verzekert Heck, is goed in lengte. In het verzenden van data over lange afstanden dus. Glasvezelverbindingen vormen het ultieme voorbeeld, maar met de hoge datasnelheden van en naar de huidige microprocessors zijn decimeters en centimeters eveneens niet te negeren afstanden. Fotonica is daarom de aangewezen technologie om in datacenters servers met elkaar te verbinden. Dit wordt al in praktijk gebracht. Energiebesparing is daartoe opnieuw de belangrijkste stimulans.

Multiplexen

De volgende stap is het verbinden van verschillende chips binnen één systeem. Het Californische bedrijf AyarLabs bijvoorbeeld beweert een technologie in huis te hebben waarmee over afstanden van enkele millimeters tot twee kilometer bandbreedtes kunnen worden behaald die duizend keer hoger liggen dan die van traditionele elektrische verbindingen, bij een tien keer zo laag energieverbruik.

Heck is ervan overtuigd dat in de toekomst de verschillende onderdelen van één en dezelfde chip met fotonica verbonden zullen worden. Dat is nu nog problematisch, omdat het om heel korte afstanden gaat, waarbij de omzetting van elektronisch naar fotonisch en terug een wissel trekt op het energieverbruik. Dat er niettemin toekomst in zit, komt door de hoge bandbreedtes die behaald kunnen worden door te multiplexen: verschillende golflengtes kunnen tegelijkertijd over hetzelfde kanaal worden verzonden. Want niet alleen bandbreedte, maar ook bandbreedtedichtheid kan in huidige chips problematisch zijn, aldus Heck. “Denk in termen van het aantal pinnetjes waarmee de chip op het moederbord vast zit. Dat is beperkt. Multiplexen is daarom een goede oplossing.” Voor dat dit allemaal goed mogelijk is, dienen er nog wel wat materiaaltechnische hindernissen overwonnen te worden. Op dit moment berust de hele halfgeleiderindustrie op silicium. Dat is helaas een materiaal dat niet geneigd is licht uit te zenden. Er wordt daarom volop geëxperimenteerd met andere materialen, zoals galliumarsenide en indiumfosfide, die wel in staat zijn binnen een chip fotonen te produceren. Maar de integratie van zulke materialen in bestaande productielijnen voor chips is niet triviaal.

Kwantumcomputers

Zodra deze problemen overwonnen zijn, voorziet Heck wel degelijk fotonische systemen die specifieke rekenkundige bewerkingen uit kunnen voeren. In theorie zijn optische computers megaparallel. Dat maakt ze geschikt voor specifieke toepassingen, zoals het doorzoeken van databases. Het Britse bedrijf Optalysys pioniert hierin. Het parallelle karakter van fotonica maakt het ook geschikt voor neuromorfische processors: chips die net als dierlijke hersenen signalen tegen elkaar afwegen. In moderne SoC’s zijn zulke modules soms al aanwezig ter ondersteuning van machine learning en AI. Heck stelt zich voor dat zulke modules in de toekomst fotonisch van aard zullen zijn. Ze zullen veel krachtiger zijn dan de huidige neuromorfische modules, vanwege het feit dat licht uitgesplitst kan worden in verschillende frequenties die parallel verwerkt kunnen worden.

Verrassend genoeg ontwaart Heck ook raakvlakken tussen fotonica en kwantumcomputing. Kwantumcomputers zijn apparaten die problemen oplossen door gebruik te maken van de meest fundamentele eigenschappen van de natuur, zoals die beschreven worden door de kwantummechanica. Volgens deze theorie, die de afgelopen honderd jaar aan alle kanten experimenteel bevestigd is, bevinden elementaire deeltjes zich van nature in een zogenaamde superpositie. Dit is een vrij complex natuurkundig concept, maar in een kwantumcomputer betekent het dat de basiseenheid van informatie geen bit is, maar een qubit. Waar een bit 0 of 1 is, is een qubit een superpositie van deze twee toestanden. Qubits kunnen bovendien met elkaar verstrengeld zijn, een mysterieuze toestand waar Einstein zelf nog zijn tanden op stuk heeft gebeten. Hoe dan ook, de theorie voorspelt dat kwantumcomputers in principe reusachtig krachtig zijn in, vooral, het ontrafelen van processen in de natuur. De verwachting is dat ze zullen leiden tot doorbraken in onder meer de materiaalkunde en de farmacie.

Wie zegt dat hij de kwantumfysica begrijpt, heeft er volgens Feynman niets van begrepen

Xanadu en PsiQuantum

De even beroemde als excentrieke natuurkundige Richard Feynman zei ooit dat wanneer iemand zegt de kwantumfysica te begrijpen, dat het bewijs vormt dat hij er niets van begrepen heeft. Onderzoekers die kwantumcomputers proberen te ontwerpen, tasten inderdaad voor een belangrijk deel in het duister. Het principe lijkt te werken, maar het blijkt uiterst moeilijk om het aantal qubits op te schalen tot het niveau waarop een apparaat werkelijk bruikbaar wordt. Elke toegevoegde qubit verdubbelt weliswaar de rekenkracht, maar dat lijkt ook te gelden voor de complexiteit van het systeem. IBM heeft niettemin simpele kwantumcomputers online staan waar geïnteresseerden nu al eenvoudige bewerkingen op uit kunnen voeren.

Fysieke qubits kunnen uit allerlei deeltjes (of grotere objecten) bestaan. Die dienen meestal wel tot bijna het absolute nulpunt afgekoeld te worden om te voorkomen dat omgevingsinvloeden de superpositie om zeep helpen. Fotonen daarentegen kunnen ook bij kamertemperatuur als qubits worden gebruikt. De Canadese start-up Xanadu presenteerde dit voorjaar ‘s werelds eerste fotonische kwantumchip. En deze zomer haalde het Californische bedrijf PsiQuantum 450 miljoen dollar op voor de ontwikkeling van de Q1: een op silicium gebaseerde fotonische kwantumcomputer met superieure foutcorrectie – een heet hangijzer in de wereld van de kwantumcomputing.

Wereldspelers à la ASML

Te midden van deze ontwikkeling rijst de vraag: in welke ontwikkelingsfase bevindt de fotonica zich als je het vergelijkt met de ontwikkeling van de micro-elektronica, als we de eerste Intel-chip uit 1971 als ijkpunt nemen? “In de buurt van 1980”, zegt Heck. Dat is een intrigerend antwoord. Dat betekent namelijk dat deze industrie een grote toekomst tegemoet gaat. Heck bevestigt dat hij exponentiële groei voor zich ziet.

Of jonge Nederlandse fotonicabedrijven zullen uitgroeien tot wereldspelers à la ASML, valt volgens Heck niet te zeggen. Dat hangt volgens hem ook sterk af van de manier waarop de huidige giganten, zoals de Taiwanese chipfabrikant TSMC, op deze ontwikkelingen inspelen. Hij benadrukt wel dat we in Nederland over ‘strategische technologie’ beschikken. De overheid onderkent dat ook. Vorig jaar nam het ministerie van Economische Zaken deel aan een investering van 35 miljoen euro in het Eindhovense SMART Photonics, maker van fotonische chips op basis van indiumfosfide. Zonder dat geld was dit innovatieve bedrijf met 75 werknemers hoogstwaarschijnlijk in Aziatische handen gevallen. Of de Wet van Moore gered zal worden door fotonica, lijkt inmiddels de verkeerde vraag. Moores vuistregel heeft eigenlijk alleen betrekking op de traditionele computerchip. Maar met fotonica slaat de computerindustrie een weg naar onbekend terrein in. Wellicht wacht aan de horizon de heilige graal in de vorm van een superkrachtige fotonische kwantumcomputer. Maar energiezuinige datacenters zijn ook de moeite waard.

De twee gezichten van het licht

Licht is een van de meest alomtegenwoordige natuurverschijnselen. Het is dan ook niet vreemd dat licht in allerlei scheppingsmythes prominent figureert. Toch bleef het lang een van de meest ongrijpbare verschijnselen. De wijsgeren van het klassieke Griekenland, die voor hun tijd zeer methodisch over de wereld nadachten, zaten verschrikkelijk fout. Epicurus (341-270 voor Christus) geloofde dat de wereld louter uit atomen en leegte bestond. In zijn Brief aan Herodotus speculeerde hij dat objecten voortdurend heel dunne, uit atomen bestaande vliesjes afscheiden. Zodra zo’n atomair vliesje ons in de ogen vliegt, wordt het object zichtbaar. Plato zat minstens even fout door te veronderstellen dat we zien doordat onze ogen stralen uitzenden. Pas in de 11de eeuw maakte de Arabische wetenschapper Alhazen korte metten met dit idee. De Hagenaar Christiaan Huygens (1629-1695) was ervan overtuigd dat licht uit een golf bestaat dat door een vooralsnog onbekend medium zou reizen. Zijn tijdgenoot Isaac Newton was het daar niet mee eens. Hij vond het gedrag van licht makkelijker te verklaren door aan te nemen dat het uit deeltjes bestond. Deze theorie werd leidend, totdat James Maxwell in 1865 voorspelde dat licht een golf is in het zogenoemde elektromagnetische veld en Heinrich Hertz dat in 1888 overtuigend bewees. Maxwells theorie vertoonde wel lacunes. Die bleken oplosbaar door te veronderstellen dat zijn golven op hun beurt uit brokjes bestaan: de zogenoemde kwanta van het elektromagnetische veld, oftewel fotonen, afgeleid van het Griekse woord voor licht. Albert Einstein ontving in 1921 de Nobelprijs voor zijn bedrage aan deze theorie. Licht bestaat dus uit golven én deeltjes Deze ‘golf-deeltjesdualiteit’ is tegenwoordig algemeen aanvaard.

Het is wachten op de eerste superkrachtige fotonische kwantumcomputer